个人感觉我在大模型应用上还是积累了很多看法,也是零零碎碎地写了很多文字记录在我的Notion里,在这里我一次性将这些经验总结成一篇文章,抛砖引玉,分享一下我在开发工作中使用大模型提效的方案。

(还有一点是AI的进展越来越快了,再不发感觉都没有时效性了,就永远发不出来了)

大模型即工具

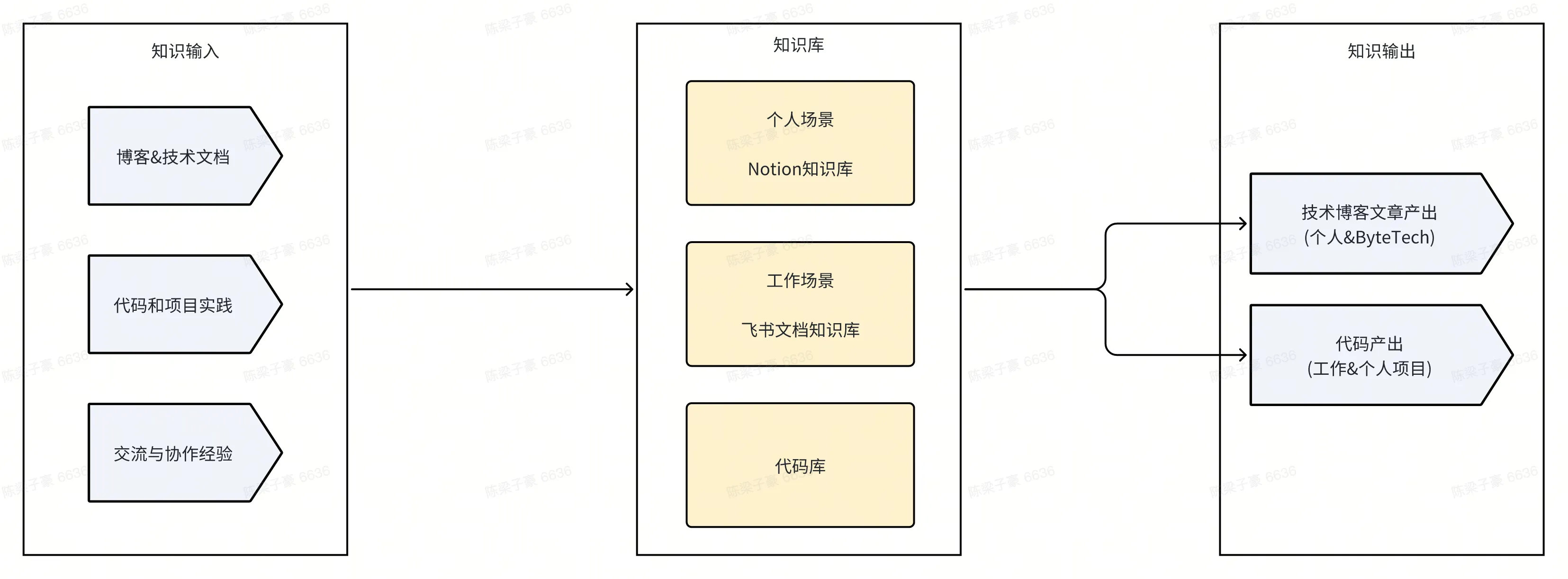

开发工作本质上也是知识型工作,工作流可以抽象为「知识收集 -> 处理 -> 产出为不同形式」。

在这个层次上,AI和传统工具并没有本质上的区别,都是作为我们大脑的延伸帮助我们提效,只是从单纯的外部数据存储变成了可以帮助我们进行一些需要「智能」的任务。

- 之前的工具比如Notion等提效的本质都是「电子笔记本」,靠电子化和自动化解放人类的「双手」,避免重复抄写等工作,帮助我们更好地收集和组织信息,但是大脑的负担并没有因此减轻

现在的AI工具具备了一定的智能,甚至工具调用能力,可以自主地完成更多任务,可以将原本需要人脑负责的部分任务交给他,真正做到了减轻人脑负担,利用人脑的特点和大模型的特点互补,进一步解放人类的生产力

- 大模型的优点是知识量丰富,阅读速度快,缺点上下文长度限制和注意力机制容易产生幻觉,擅长处理信息收集和汇总、执行短上下文且定义明确的任务,在这类任务上的执行效率和效果往往比人类更高,如总结网页和音视频内容、编写单测代码/正则表达式、执行小型代码重构等

- 人脑的优点是上下文超长,可以真正理解大型知识库,且信息来源更丰富,缺点是吞吐量相比大模型较低,擅长处理架构问题等需要考虑复杂情况和权衡的情况,可以理解为领导只关注大局,具体细节则交由员工(大模型)去实现,起到统领全局和传递必须的上下文信息的作用

不同的工具在不同的流程中发挥着不同的作用,因此我们可以根据场景来对AI工具的应用进行划分,可以更好地认识到不同AI工具在实际生产过程中的具体价值和使用方法。

这里我就按照流程和场景对我下面提到的AI工具进行简单梳理:

| AI产品类别 | 知识输入 | 知识处理 | 知识输出 |

| 传统聊天Bot(如ChatGPT、豆包、POE等) | ✅ 信息查询 | ✅ 总结、摘要、重写 | ❌ |

| AI联网搜索引擎(如Perplexity) | ✅ 信息查询和调研报告 | ❌ | ✅ 直接生成调研报告 |

| AI开发Agent(如Cursor) | ✅ 解读现有代码库 | ❌ | ✅ 协助完成开发任务 |

我正在使用的AI产品

付费产品都会标注💰并提供免费替代方案

💰 Raycast AI:结合本地的聚合LLM Agent平台

如果你对Raycast感兴趣,点击这里即可下载

免费平替方案:

✅ AI服务:豆包 & Deepseek & Ollama

✅ Raycast:免费版(提供启动器和插件功能)+Ollama/ChatGPT插件(绑定Ollama或API)

无法覆盖的功能:

❌ 和系统级的上下文直接交互,如Notion、终端等

❌ 基座模型能力,如Claude的MCP等

Raycast现在是我的主力模型平台,它承载了日常交流中80%以上的对话和咨询,包括模型对话、联网查找等。

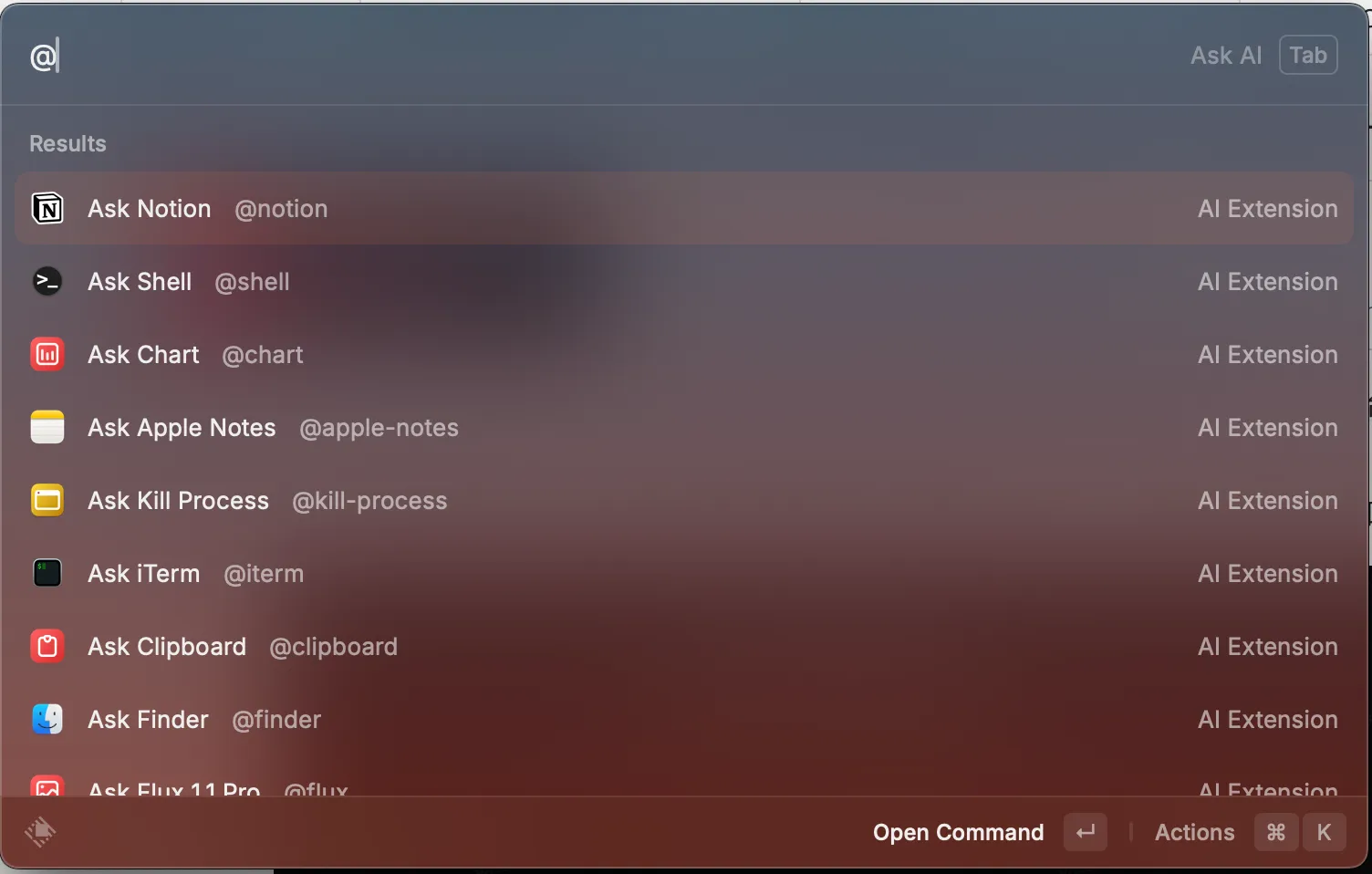

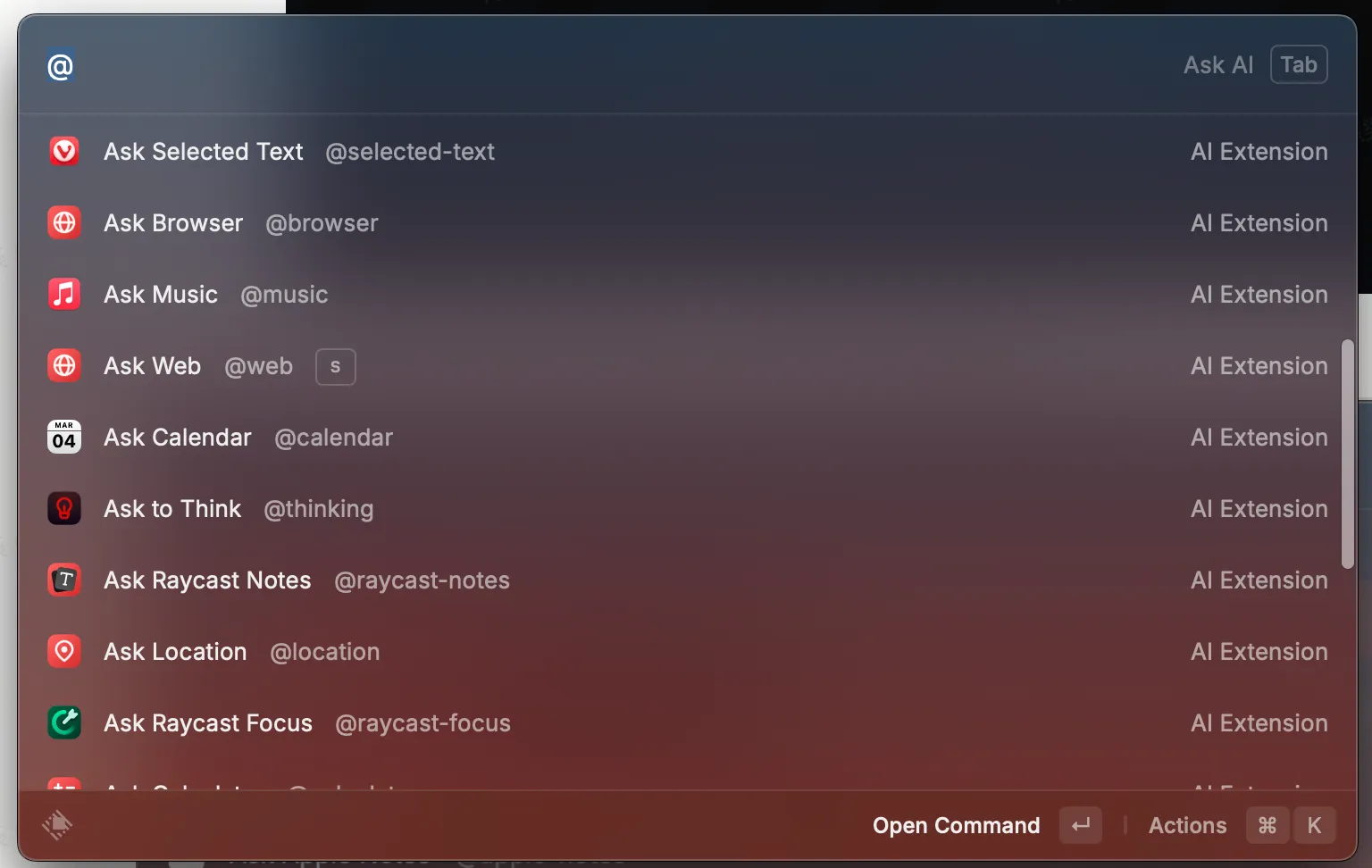

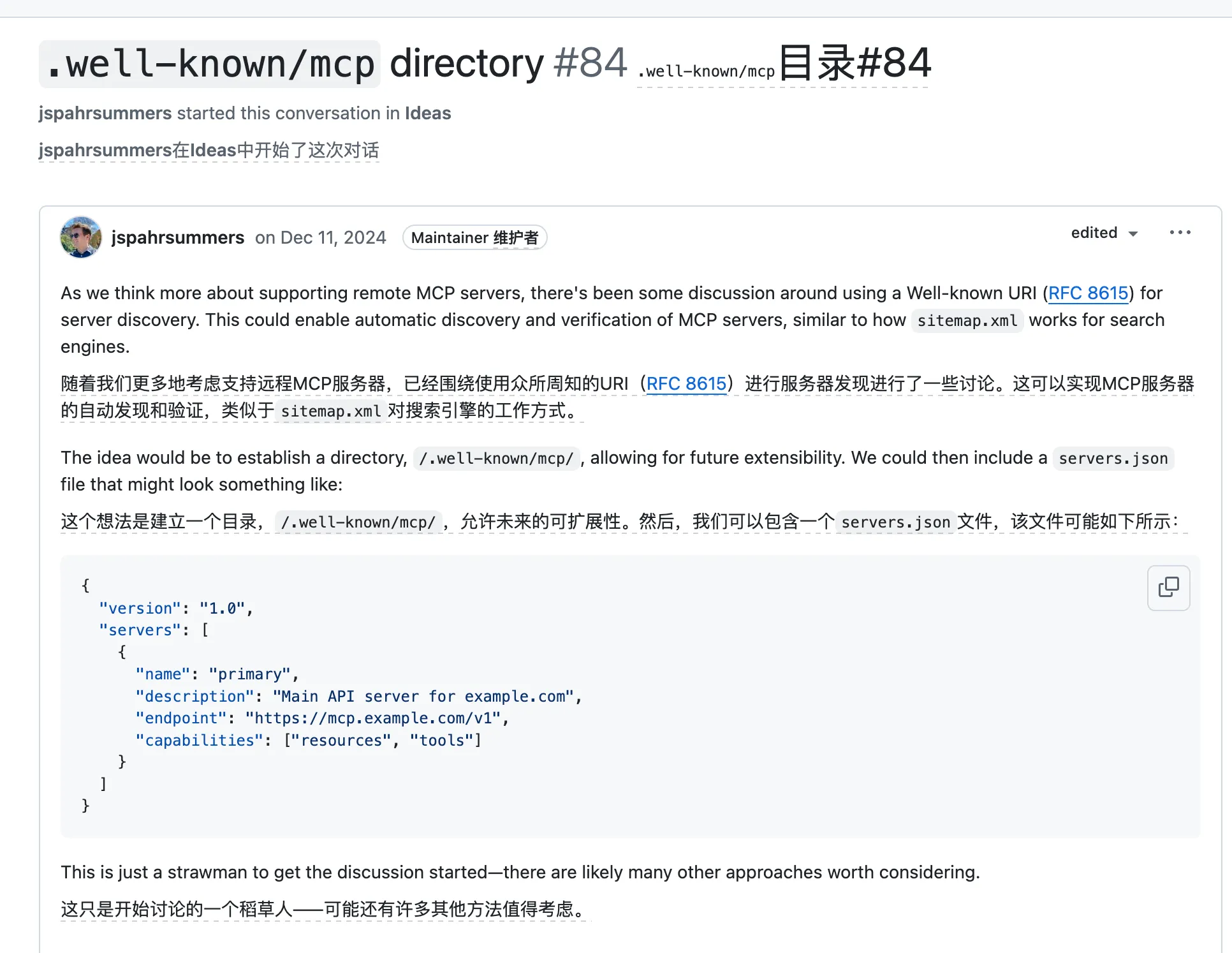

大模型的基础还是进行语言聊天,但是随着技术的不断迭代,多模态、function call等技术突破让大模型不再局限于文字上下文,而是识别图片、自主调用工具,从Chat(被动地接受文本后输出)变为Agent(主动获取信息并和外界交互)。

为什么我从POE.com切换到Raycast

在这之前,我的主力模型平台是POE,它的优点是用和GPT/Claude一样的价格($20),可以一站式地体验到所有的模型,包括主流语言模型、推理模型、图像生成模型、音视频生成模型等。

但是,它有一个比较明显的缺点——用户体验上没有进步,现在大部分的主流在线大模型交互平台都在交互上有各种各样的花式创新,而POE感觉在Agent能力上没有任何进步的趋势。

| Poe | ChatGPT | Claude | |

| 推理模型 | ✅ 所有模型 | ✅ o1&o3 | ✅ 3.7 Reasoning |

| 实时预览 | ✅ | ✅ Code Interpretor & canvas | ✅ Artifact |

| 主动执行操作 | ❌ | ✅ Computer Use | ✅ Operator |

| 调用工具 | ❌ | ✅ function call | ✅ MCP |

| 绘图模型 | ✅ 需要切换第三方模型 | ✅ 集成DALL-E可以直接画图 | ❌ 通过MCP间接调用 |

| 视频生成 | ✅ 需要切换第三方模型 | ✅ Sora | ❌ 通过MCP间接调用 |

正值此时,Raycast带来了一个重磅更新:将整个电脑的能力都暴露给大模型,让Raycast成为了一个大Agent。

https://www.raycast.com/changelog

这一升级,让Raycast AI直接从一个无足轻重的订阅服务提供商变成了非常有竞争力的AI生产力平台,对比POE,在价格和功能性上基本完胜。

| POE | Raycast | |

| 价格 | $20/月(年费$18) | $10/月(年费$8) |

| 聚合语言模型 | ✅ 所有模型 | 🤔 主流模型,包括GPT所有模型、Claude所有模型和所有开源LLM模型 |

| 多媒体模型 | ✅ 所有模型 | ⚠️ 仅支持DALL.E、StableDiffusion和Flux |

| 代码执行与预览 | ✅ 支持HTML、JSX和Python | ❌ 不支持 |

| 快捷入口 | ❌ 浏览器/套壳Web应用,不支持URL快速访问 | ✅ 启动器直接访问 |

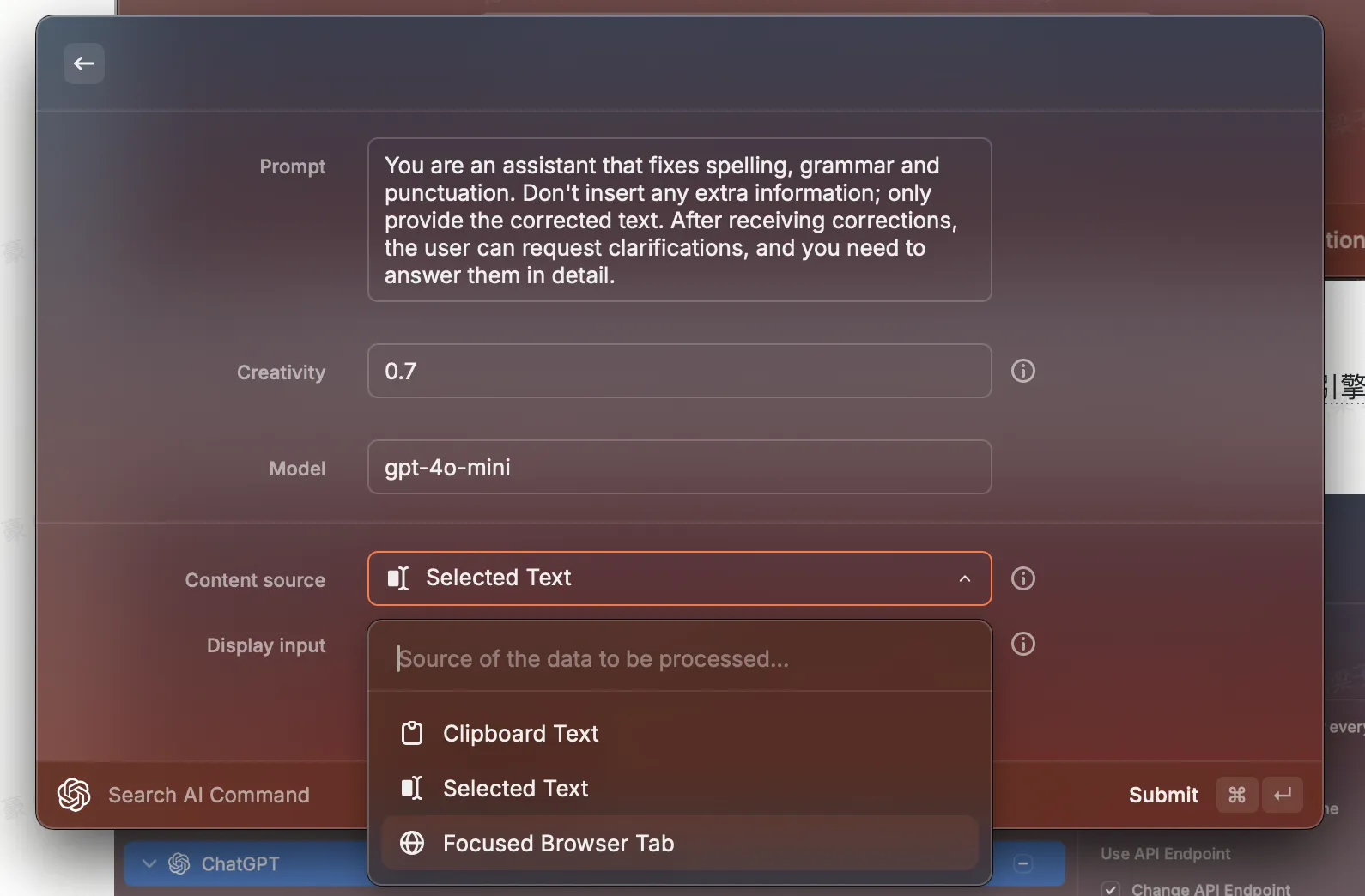

| 编辑系统Prompt | ✅ 支持创建智能体 | ✅ 支持创建Preset、Command,快速处理相关场景和指定任务 |

| 上下文获取 | ❌ 用户自行获取并提供给聊天 | ✅ 支持获取第三方数据源,包括网络搜索、电脑中的第三方应用 |

| 工具调用 | ❌ 不支持配置工具 | ✅ 支持调用电脑上的工具,但是尚不支持自己配置MCP工具 |

上面标绿的部分,就是我从POE转向Raycast的核心理由,有一个能覆盖之前我所有需求、更便宜且还功能性更强的选择,我没有任何理由留恋之前的平台了。

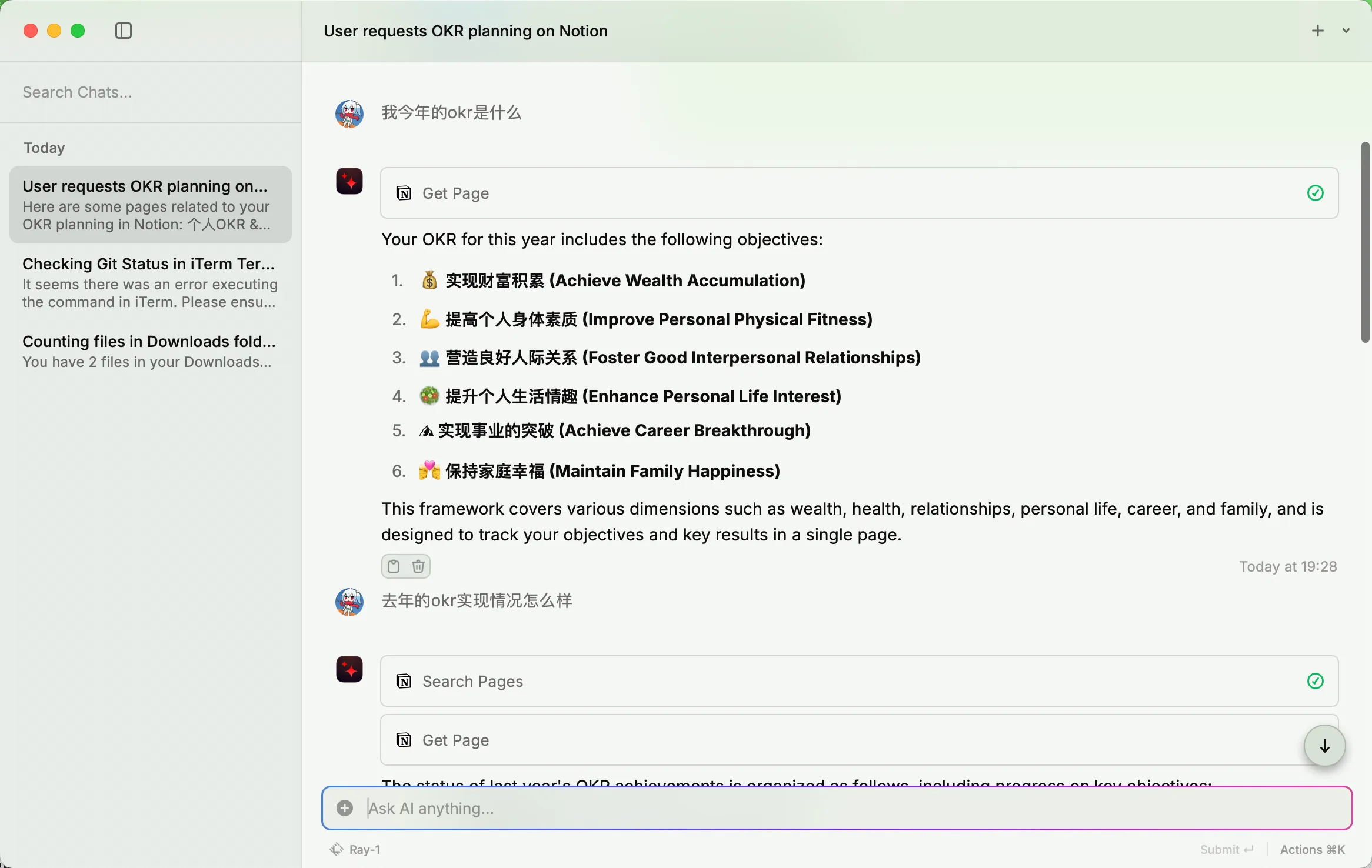

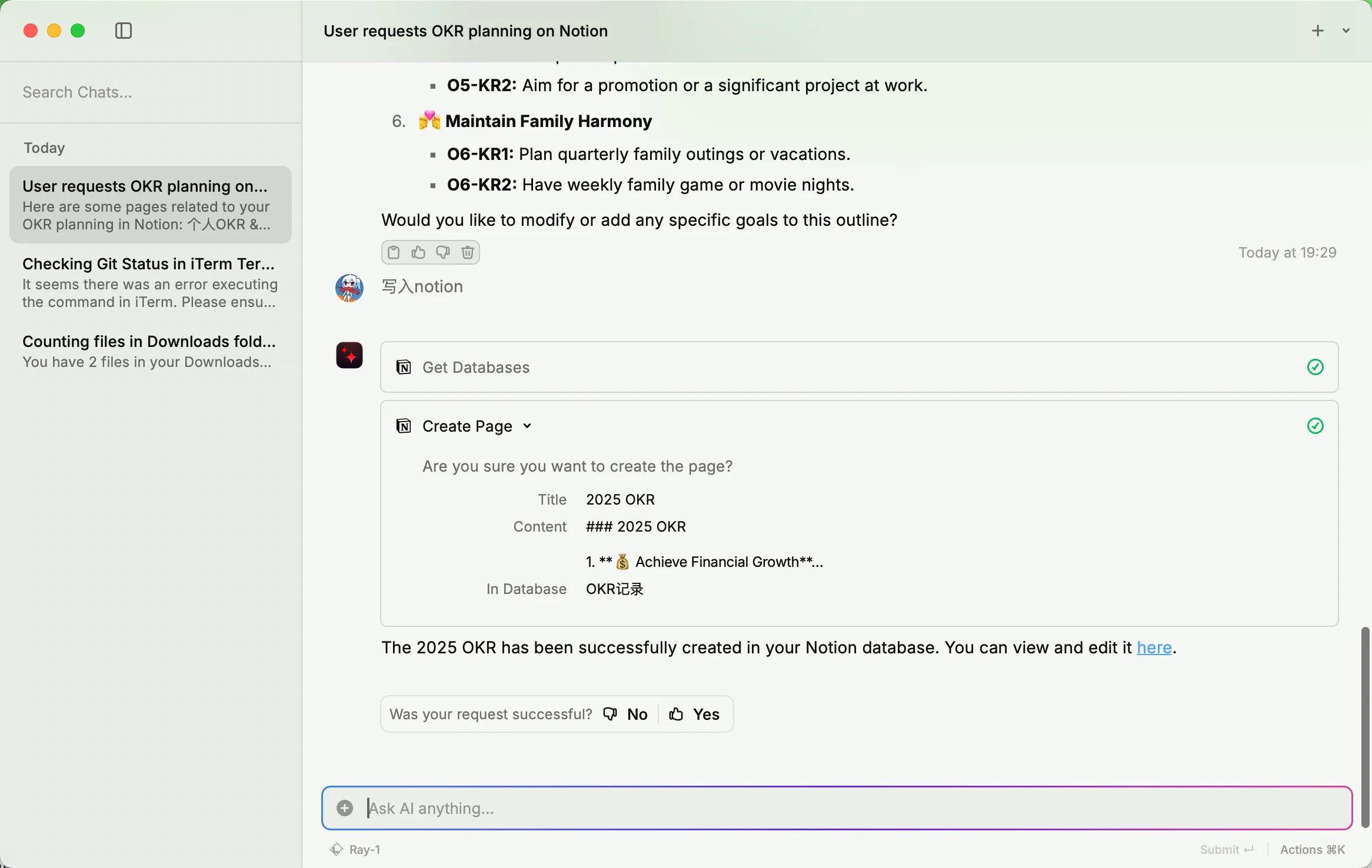

Raycast的王炸:与本地工具的深度集成

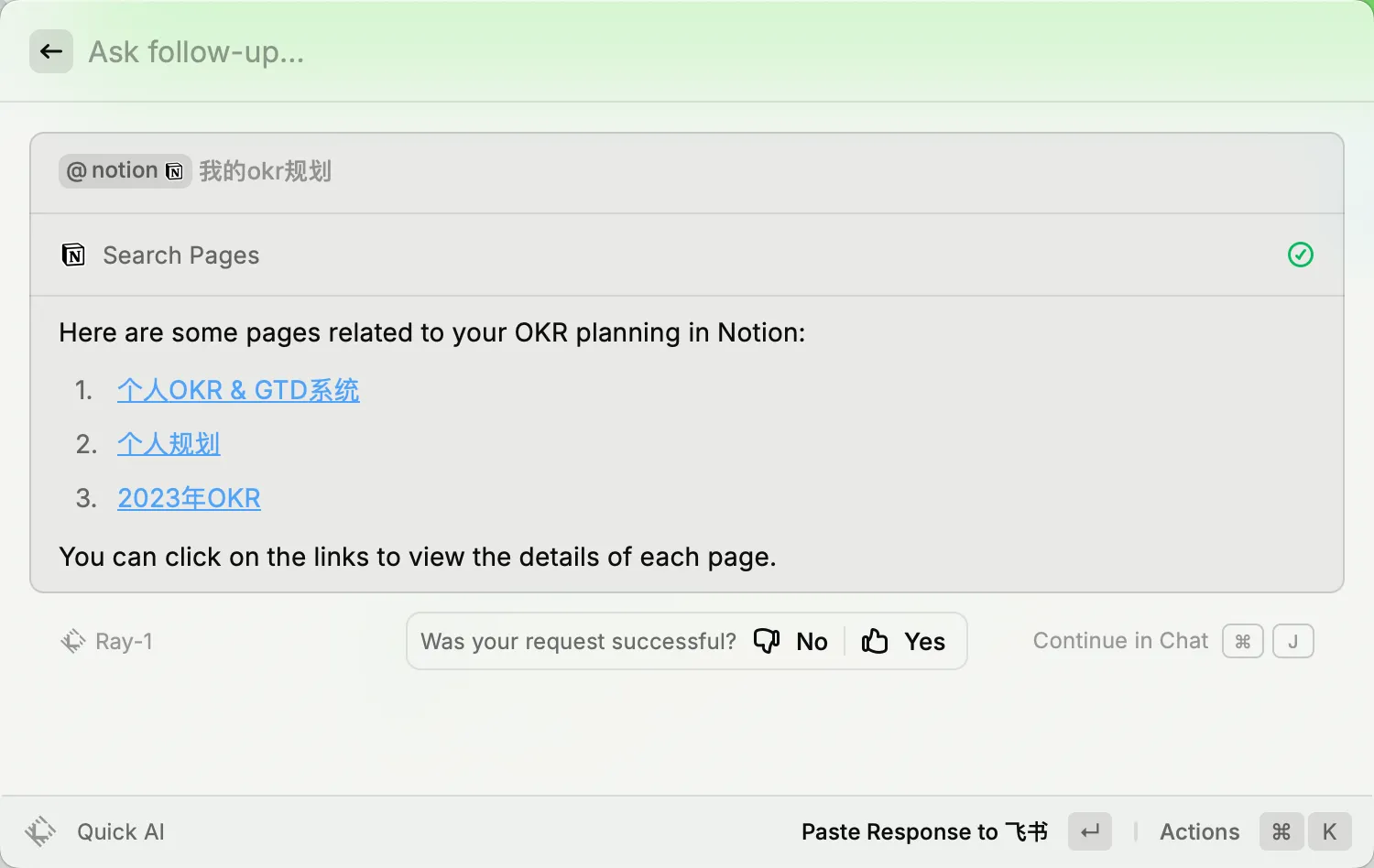

作为启动器,提供先前POE无法提供的上下文信息并调用我本机的工具,如直接从剪贴板或本地应用(Notion, 备忘录等)获取信息,或者执行Shell命令、操作Finder等,甚至可以替代我一部分其他AI工具

帮我直接操作终端,当赛博拐杖

替代Notion AI,读取和操作Notion知识库

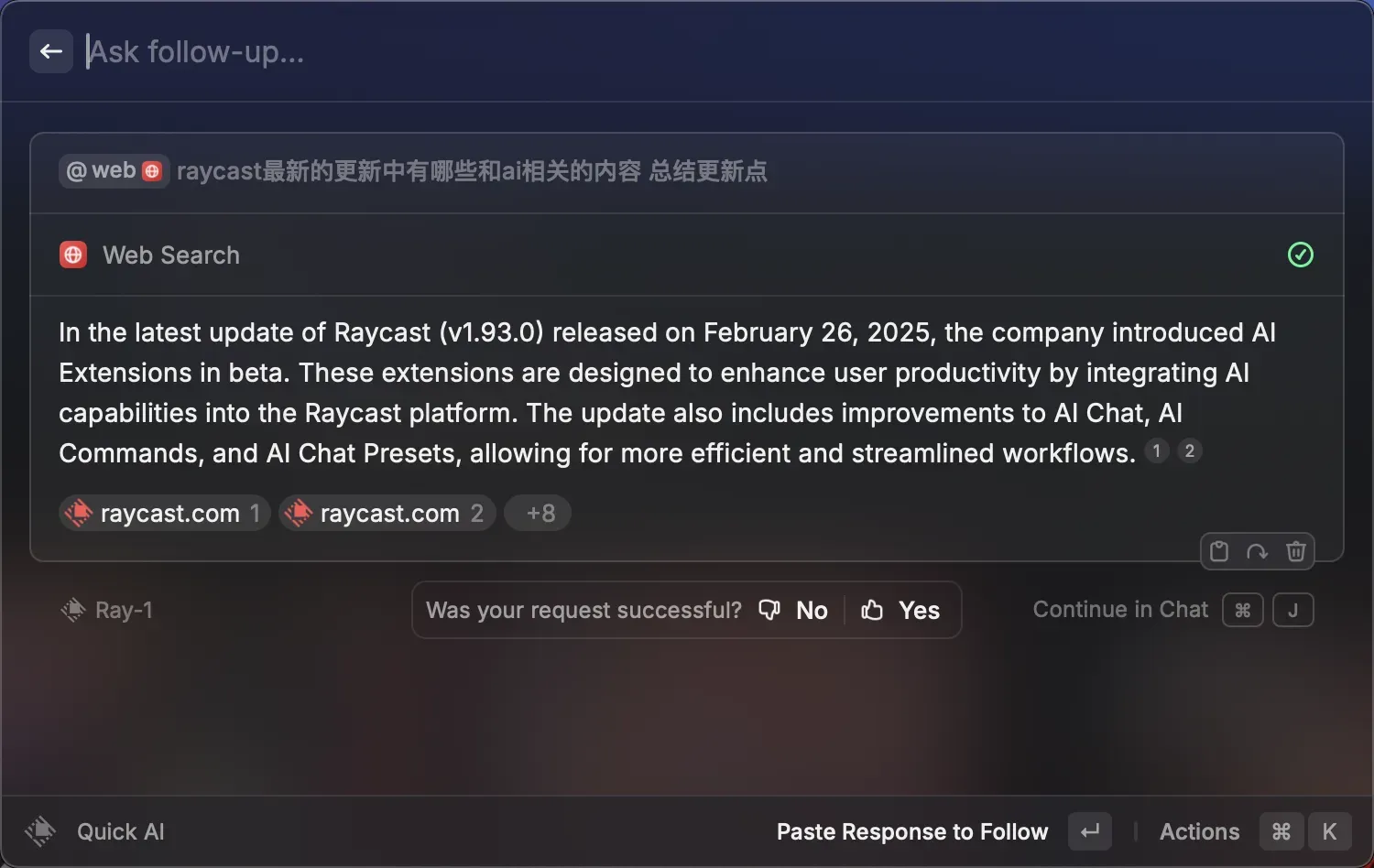

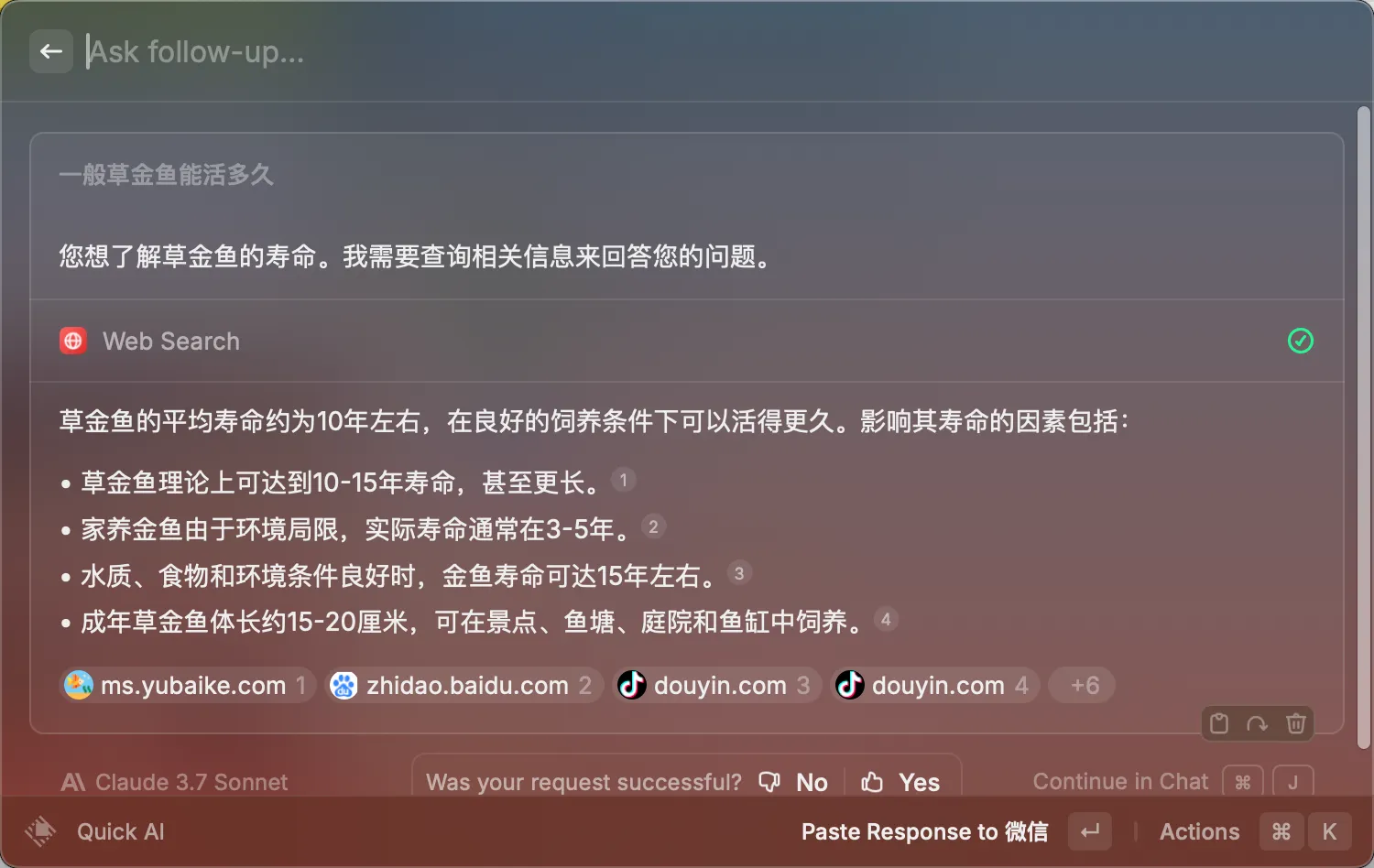

替代Perplexity,快捷执行网络搜索

使用

@web指令,显式调用搜索工具进行网络搜索

使用支持Web Search的模型(如Claude)作为快捷模型,Tab快速询问也能支持搜索

自定义方案:Ollama + 第三方API

Raycast Store中的Ollama和ChatGPT插件,更方便地调用API进行聊天,通过一些配置也可以还原大部分的Raycast AI功能,且完全不用额外付费。

Ollama体验

Raycast中可以直接管理Ollama模型和聊天记录,不用单独起一个Open WebUI的网页服务。

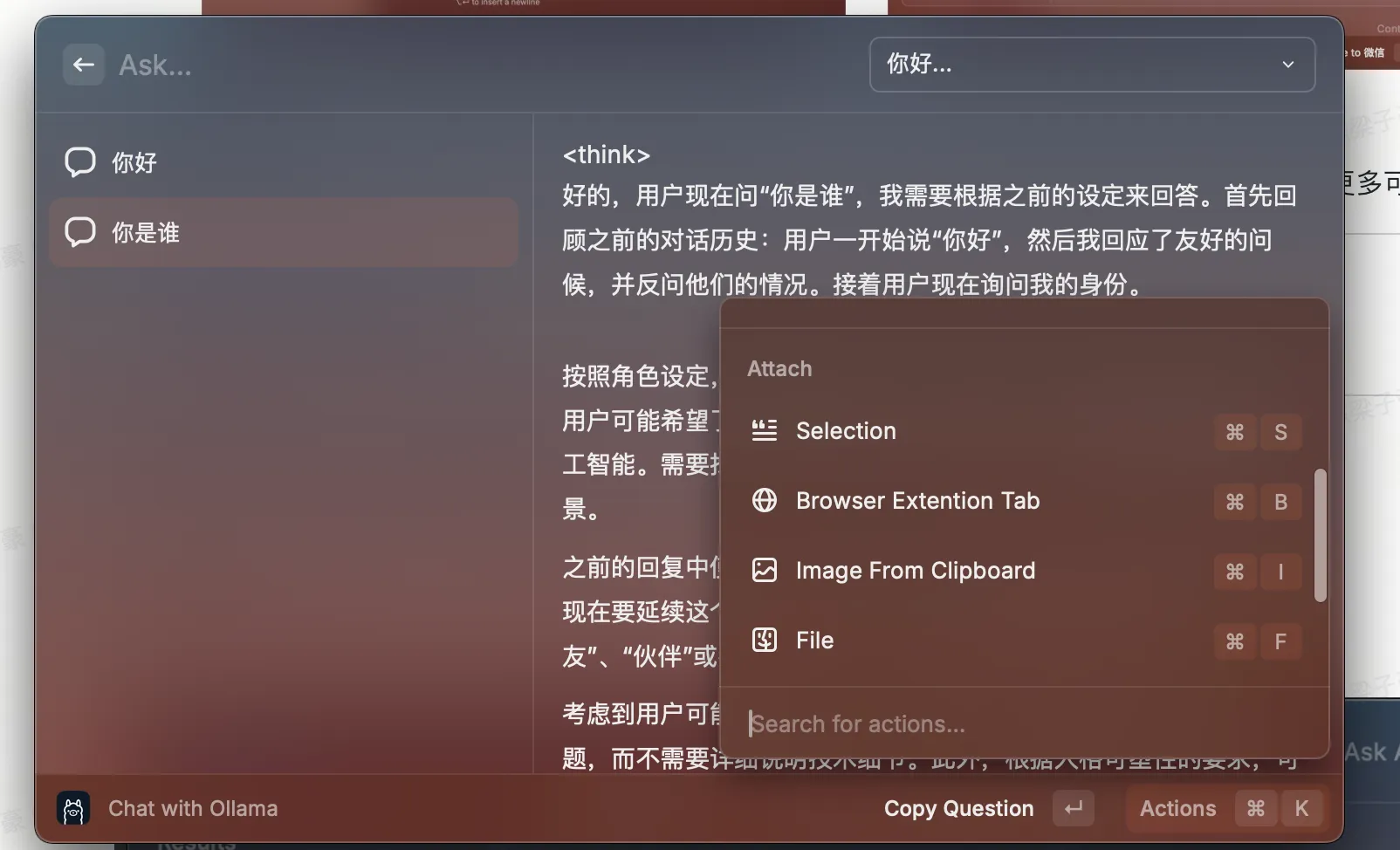

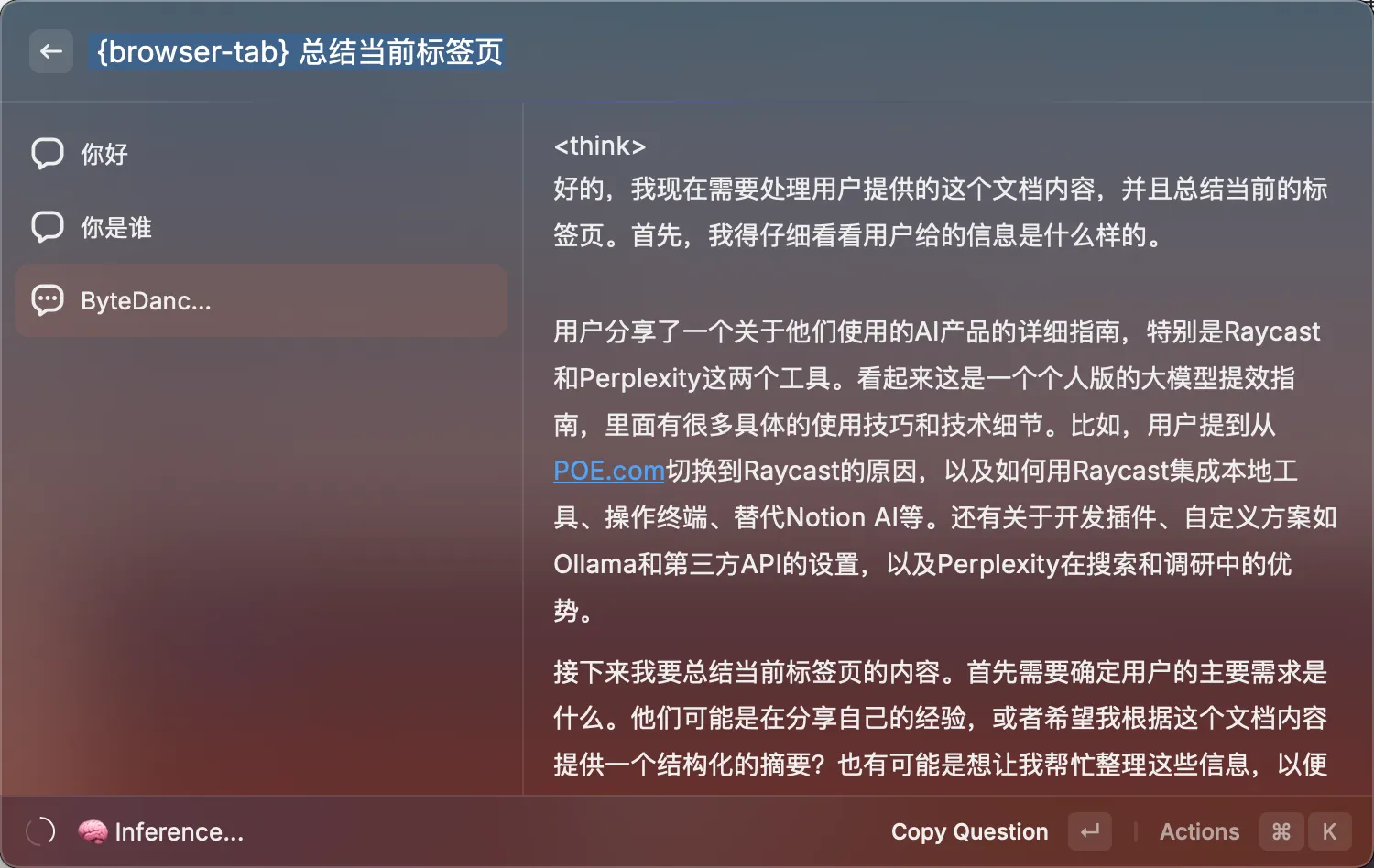

在Chat功能中,Raycast可以方便地添加各种上下文,比如标签页啥的:

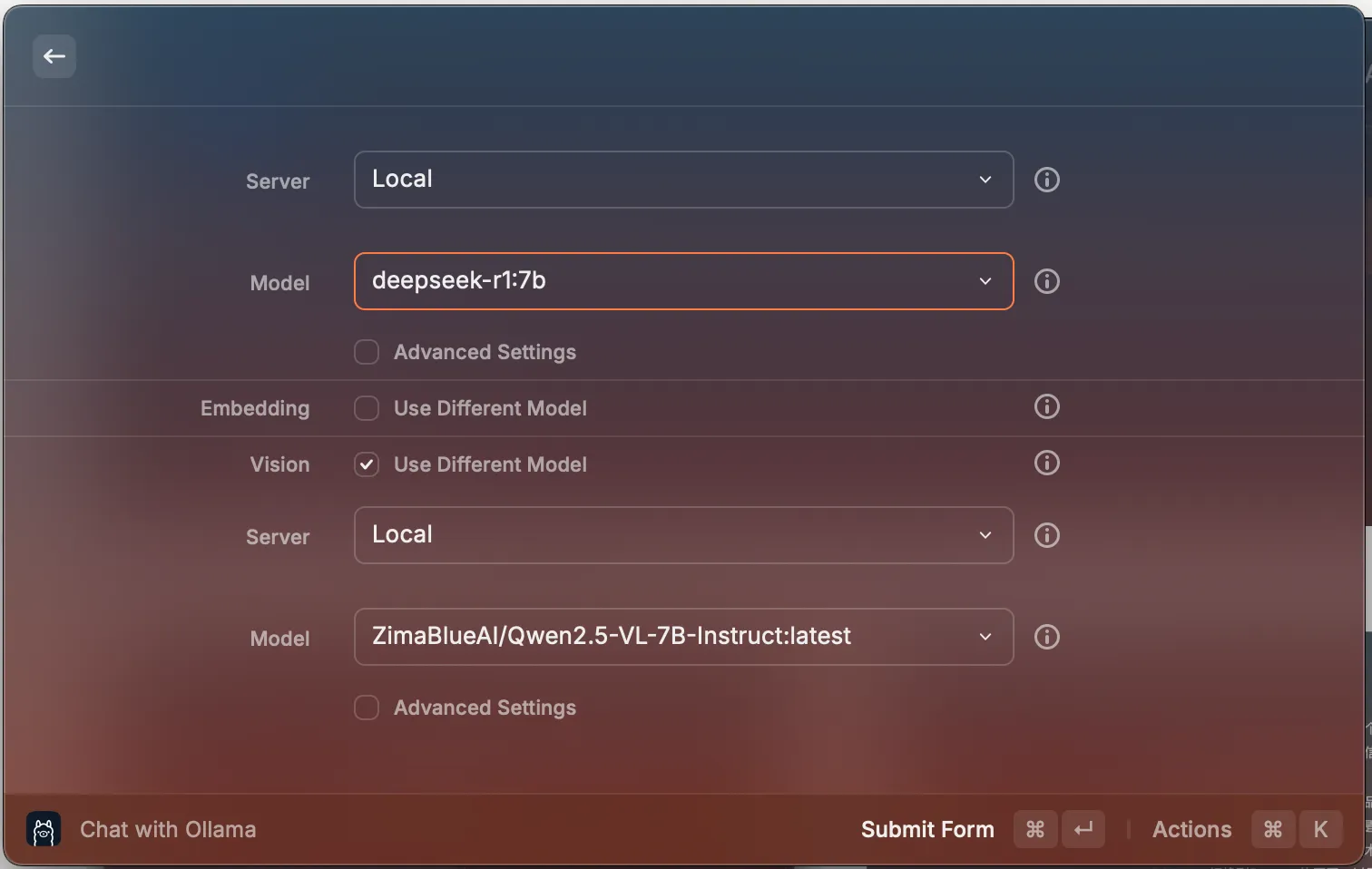

同时,Raycast还支持针对不同场景配置不同的模型,这对不支持多模态的推理模型非常实用,比如我的日用搭配就是Qwen2.5-VL+DSR1-7b,跑在36G+M3Pro上还是比较流畅的。

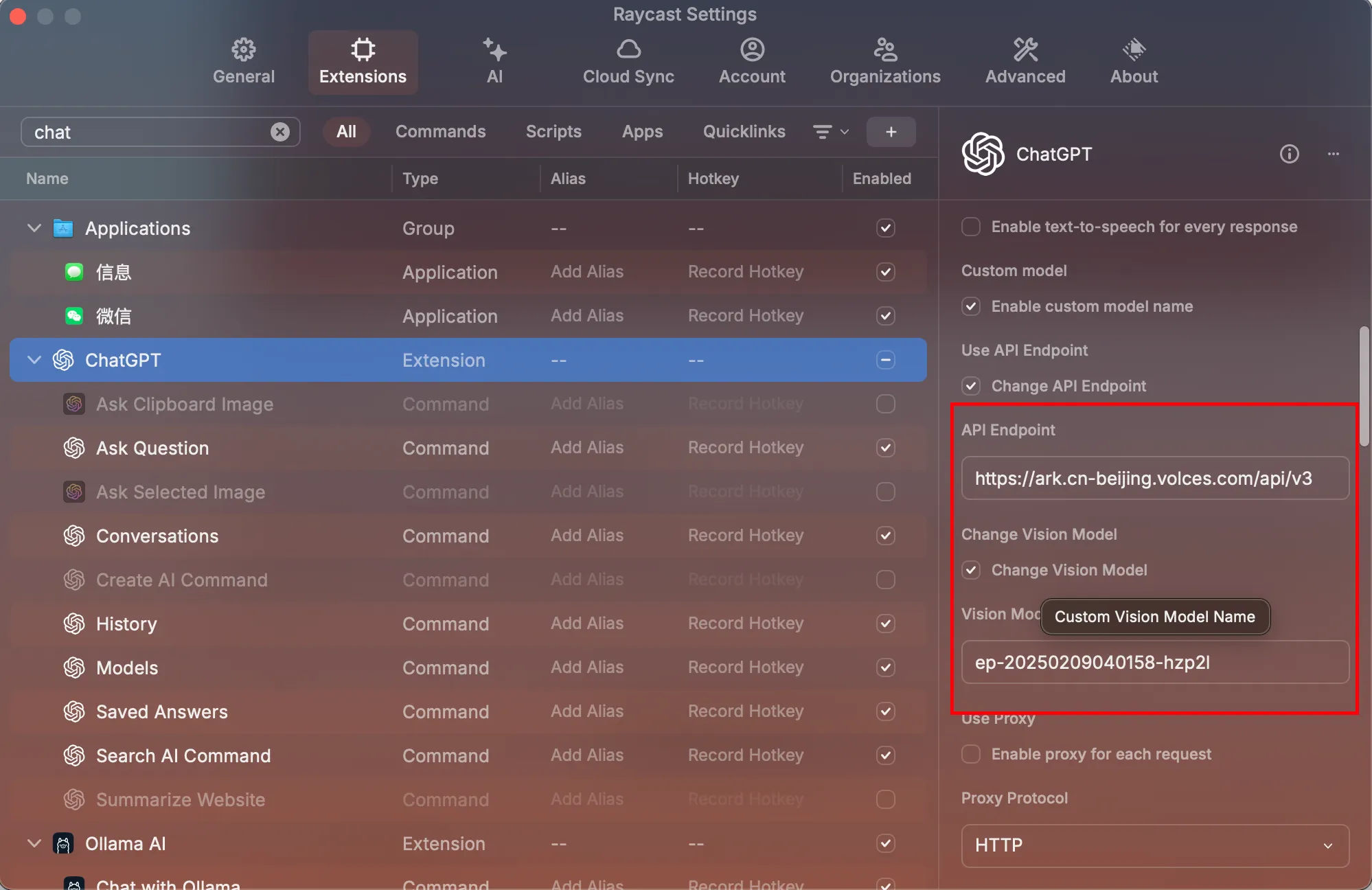

第三方API接入

除了本地运行模型外,还可以利用ChatGPT插件接入云端第三方API端点,比如我这里就接的是火山引擎的端点,模型搭配为DeepseekR1满血版+Doubao1.5Pro(视觉模型)。

同样的,这里也支持如多模态输入、自定义视觉模型、保存回话历史、创建自定义AI指令、获取本地上下文等功能,就不再详细展示。

Perplexity:帮你执行搜索和调研

Perplexity是最早做AI搜索引擎的一批公司,现在这个领域的技术壁垒已经打破,可以根据开源方案自己构建AI Web搜索引擎(如Perplexica),也有很多竞争者(比如许多模型内置的联网搜索功能),但Perplexity靠自己证明了它们的成功更多的是产品层面的把控,在精准搜索和研究的体验目前个人体感还是无出其右(而且咸鱼200就能拿下年费Pro)。

在查找某个陌生API用法或者对某个新领域进行调研时,Perplexity的专业搜索是非常好的帮手。

AI搜索的出现,可以说完全颠覆了我的信息获取流程。面对一个全新的领域或名词,在AI搜索出现前后,我的工作流程如下:

AI搜索出现前

- 提取一个最笼统的关键词或相关关键词,比如我要查询某个npm包,我可能会搜索

react swiper npm - 找到一个最相关的结果,阅读相关文档了解关键概念

- 查询相关概念,比如accessibility支持、draag事件、轮播图(carousel)组件等

- 查询类似产品,比如搜索

alternatives for react-carrousel,或在npm中搜索关键字react,carrousel - 对比类似产品,总结这个领域的相关概念和最佳实践,一套下来可能半天就没了

AI搜索出现后

基于Pro Search的问题理解和拆分能力

- 询问第一个问题:目前有哪些xxx解决方案,最佳实践是什么?按照github star数进行排序?

基于之前的方案进行追问:

- 详细介绍xxx方案

- 解释xxx概念

- 还有没有xxx

整套流程可以缩减到20分钟以内,即可快速了解一个领域

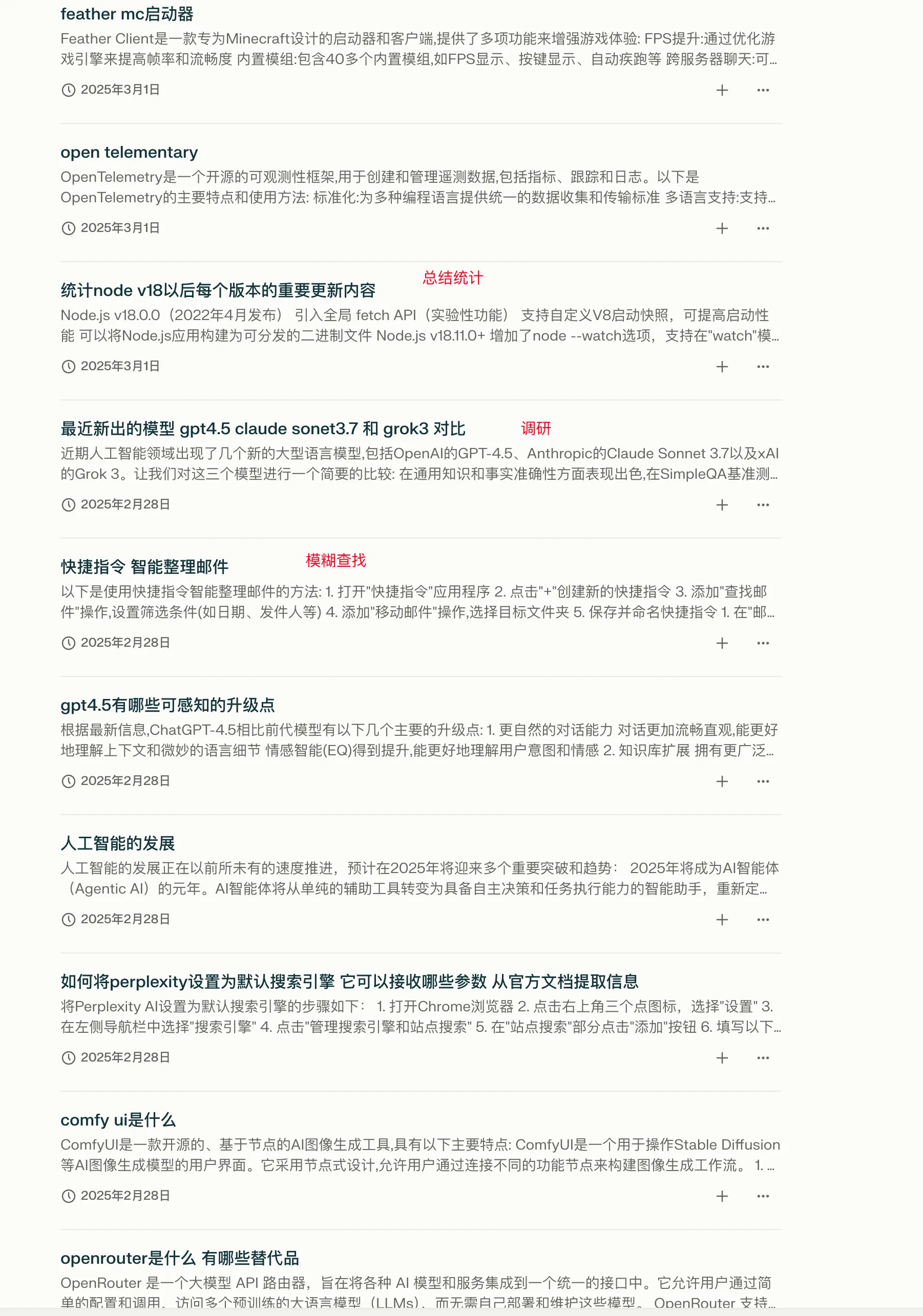

下面是我近期使用Perplexity的查找记录,基本都是传统搜索难以覆盖或者工作量很大的领域,PPL为了节省了大量的时间,而其他的搜索工具都太简陋了,PPL这种专门的AI搜索工具像是有一个人在帮我查资料做总结,而其他工具则像是提供了一个「顺手查查资料」的途径。(移动端豆包做的还是很不错,但是专业搜索感觉还是差点意思)

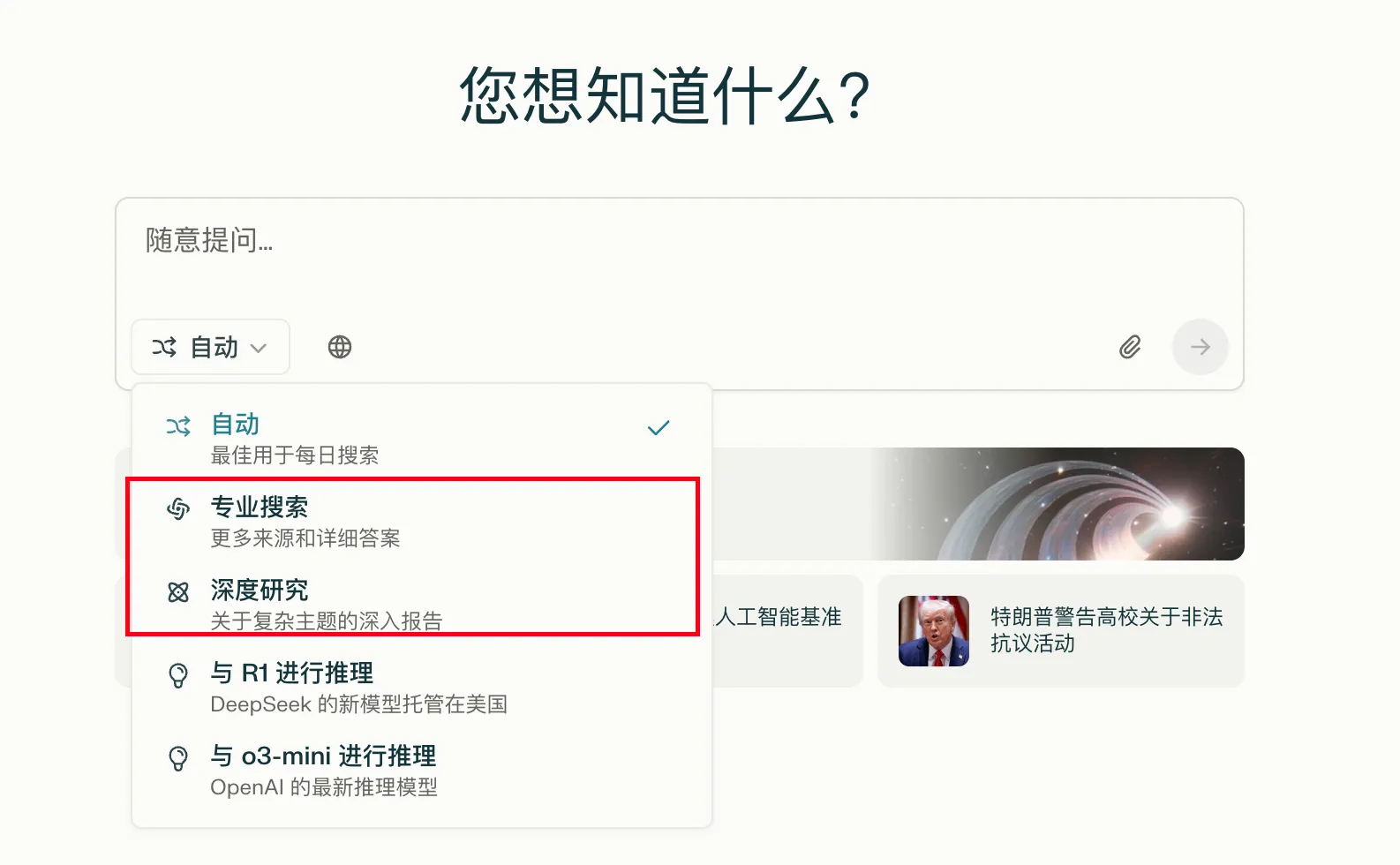

Pro搜索

需要指明的是,大部分情况,甚至做新领域调研这种相对需要思考能力的场景,普通(免费版)搜索已经完全够用了,Pro的优点在于会先构建思维链再去搜索和总结,会查询更多资料,获得更翔实的回复。

对于Pro订阅用户,Perplexity自然也端上了自己最核心的工具——Pro搜索,和最近新增的Deep Research。

相比于普通搜索,Pro Search的主要区别是多了一个前置思考的功能,可能会消耗更长的时间,但可以得到更充实和准确的答案。

- 分析你的输入,提取关键词,执行多轮搜索

- 使用更高级的模型(如Claude3.5和GPT4o)来进行总结和汇总

大部分情况下切换到Pro搜索都是无害的升级,但大部分场景其实又不太需要Pro搜索。普通用户每天有5次使用Pro搜索的机会,而Pro订阅用户则有300次。

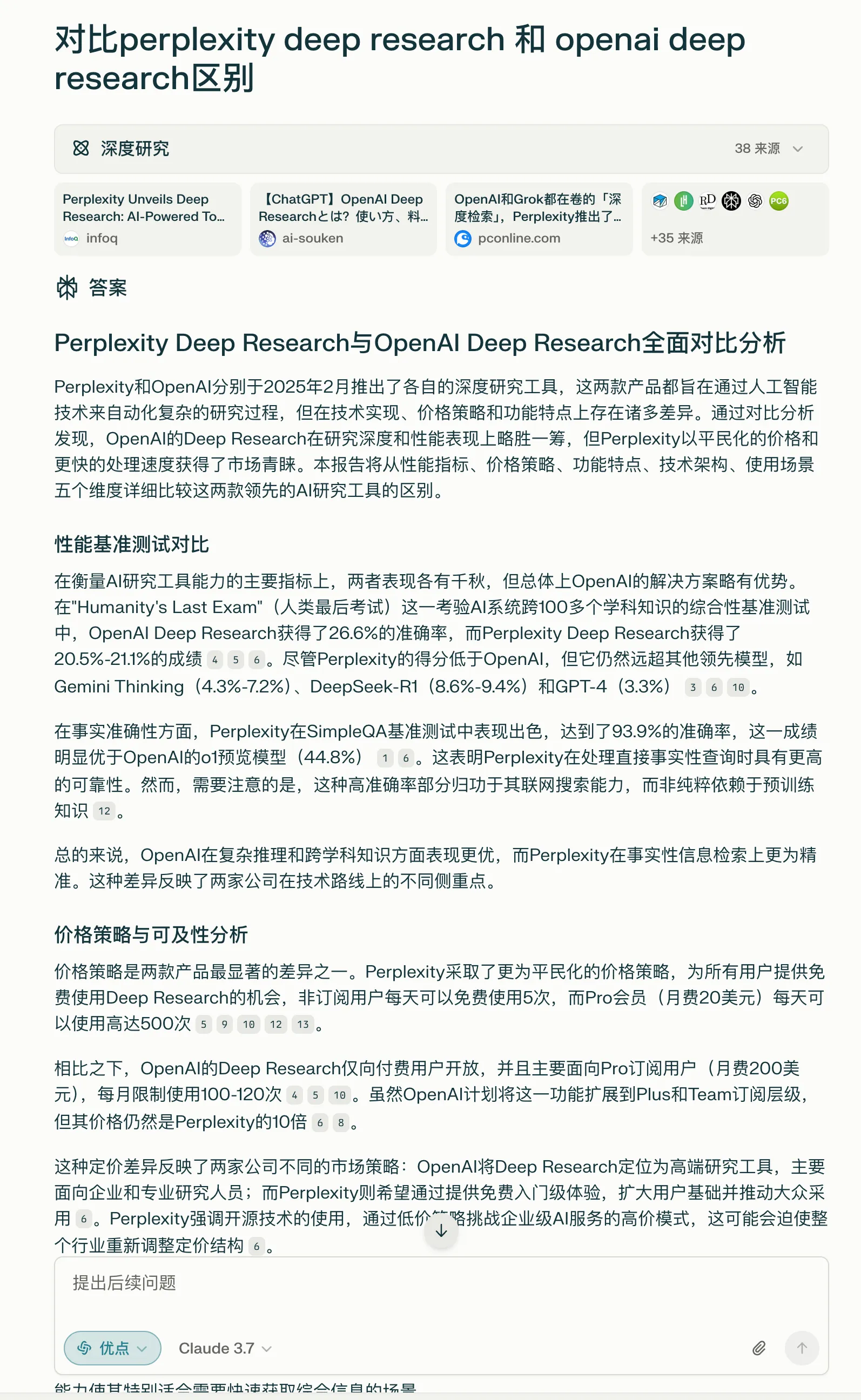

Deep Research

OpenAI此前基于o3推理模型推出了深度研究(Research Mode),但该功能仅针对200刀的ChatGPT Pro,根据其官方博客介绍,Deep Researc相较于传统搜索有以下区别:

- 基于o3推理模型构建,会深入分析输入的问题并制定详细的研究计划

- 具有工具调用(function call)能力,并为其配备了网络查询、Python代码编写和执行等能力,帮助其完成研究

传统AI搜索像是「找一个人帮你组织keyword,查找资料后进行整合」,而Deep Research则是「找一个会查资料、跑代码、画图的专家帮你完成一份调研报告」,在专业性上更上了一个档次。

但是,随着Deepseek R1的出现,推理模型开始飞入寻常百姓家,于是Perplexity推出了自己的Deep Research,还非常慷慨地给免费用户提供了每天5次的调用。

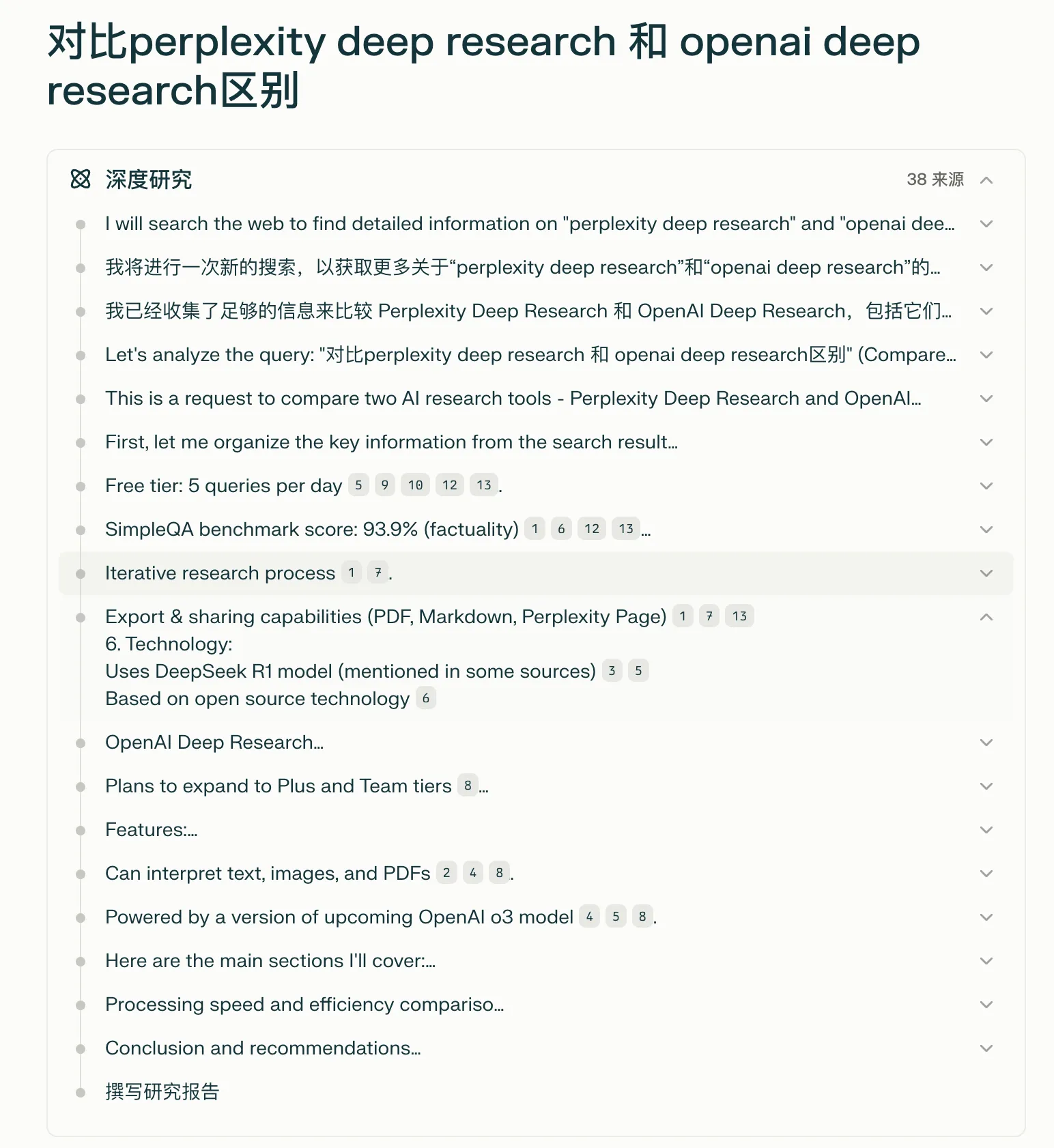

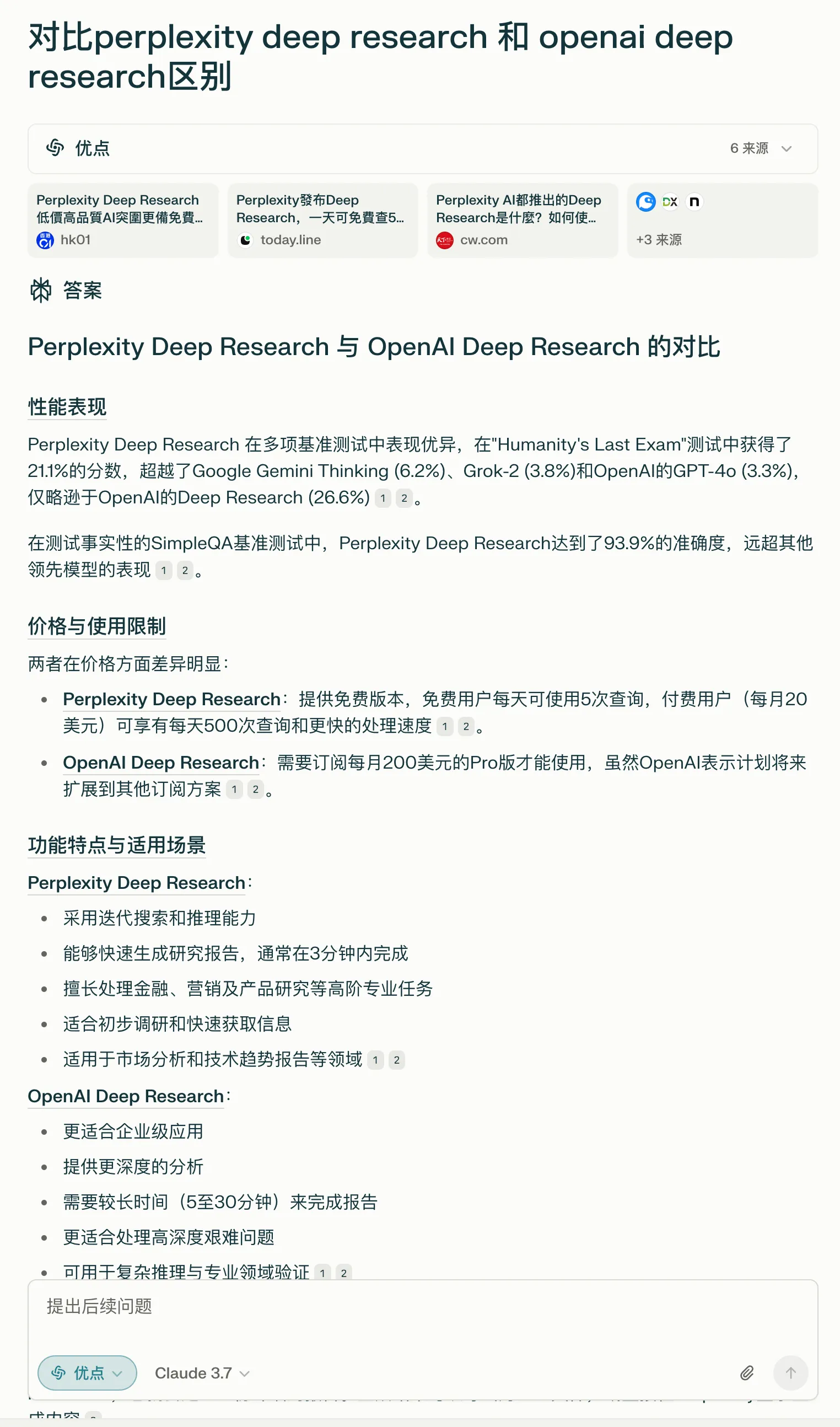

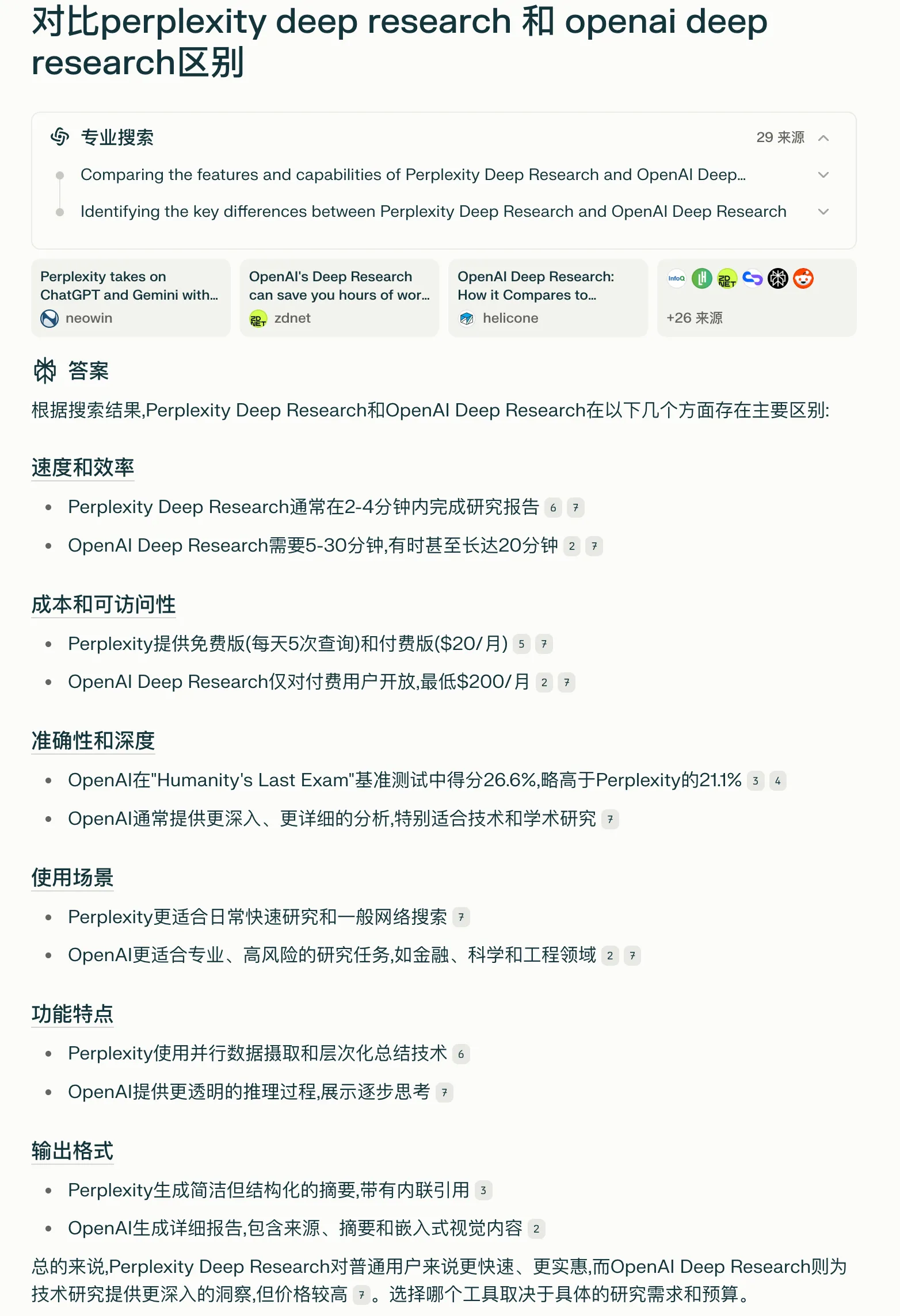

那么,Perplexity的Deep Research和OpenAI的有什么区别呢?这里说说我的看法。

- OpenAI基于o3模型训练,具有强大的工具调用能力,而PPL则基于R1开发,工具调用能力较弱,更倾向于分析查询条件和整合资料

- OpenAI的Deep Research在流程上更像是主动调用各种工具去进行调研,更像是真正的「思考过程」,比如查询资料、解析PDF、执行Python代码进行绘图制表等,思考时间最长可达30分钟

- 而Perplexity的思考过程更像是针对「分解搜索任务」特调的R1推理过程,基本只能使用搜索工具,更像是Pro搜索的升级版而不是研究Agent,比较简陋,一般3分钟内就可以完成

效果对比实测

这里简单对比了一下同一个问题下不同模式的对比,可以看到越高级的模式资料来源越多,推理时间越长,最后的产物也更丰富。

个人使用建议

从我个人的使用经验来看,高级功能的使用建议如下:

- 日常搜索任务使用普通搜索完全足够,可以节约收集资料的时间,并通过多轮追问获取更多信息

- 对于Pro用户,直接无脑全用Pro搜索即可,可以支持复杂的查询任务并生成完整的结果

- Pro搜索可以通过编排Prompt(无需PE),合并查询任务让AI去拆分执行来节省搜索积分,300次完全足够了

- 如果是免费用户或者搜索轮次较多的用户,可以日常使用普通搜索,必要时再使用Pro搜索

- DeepResearch目前看来是Pro搜索的增强版,搜索时间比较长,但效果并没有好很多,因此目前看来实用性是比较低的

💰 Windsurf

Windsurf是我日常使用的AI IDE,增强补全、仓库上下文对话、本地规则、自动开发、MCP插件等功能一应俱全,做到了AI IDE的一线水准。

后续会更新一期专门讲如何使用Project Rules+MCP集成,让Agent直接帮忙开发本地已有的项目。

同类产品功能对比

个人推荐:

- 免费产品:Trae + Cline

- 收费产品:Cursor > Windsurf

| Cursor | Windsurf | CLine/Roo Code | Trae | Continue DEV | Marscode | |

| 价格 | $20/M | $15/M | Free | Free | Free | Free |

| 超级补全 | ✅ | ✅ | ❌ | ✅ | ❌ | ✅ |

| 内联AI(终端等) | ✅ | ✅ | ❌ | ✅ | ✅ | ✅ |

| 仓库上下文感知 | ✅ | ✅ | ❌ | ✅ | ✅ | ✅ |

| 全自动Agent | ✅ | ✅ | ✅ | ✅ | ❌ | ❌ |

| 自定义规则 | ✅ | ✅ | ✅ | ❌ | ✅ | ❌ |

| 全局记忆 | ❌ | ✅ | ❌ | ❌ | ❌ | ❌ |

| MCP集成 | ✅ | ✅ | ✅ | ❌ | ✅ | ❌ |

| 非代码上下文(如自定义文档、Git等) | ✅ | ⚠️ 仅支持预设文档 | ❌ | ❌ | ✅ | ❌ |

| Git Commit MSG | ✅ | ❌ | ❌ | ✅ | ❌ | ✅ |

为什么不是Cursor?

- Codeium是我一直在使用的AI插件,感情深厚

- Codeium团队相比Cursor团队会在博客中披露更多技术细节,比如他们为什么要这么做,我可以学习他们设计AI产品的思路

- 比Cursor便宜5刀,功能几乎一样

实际使用场景

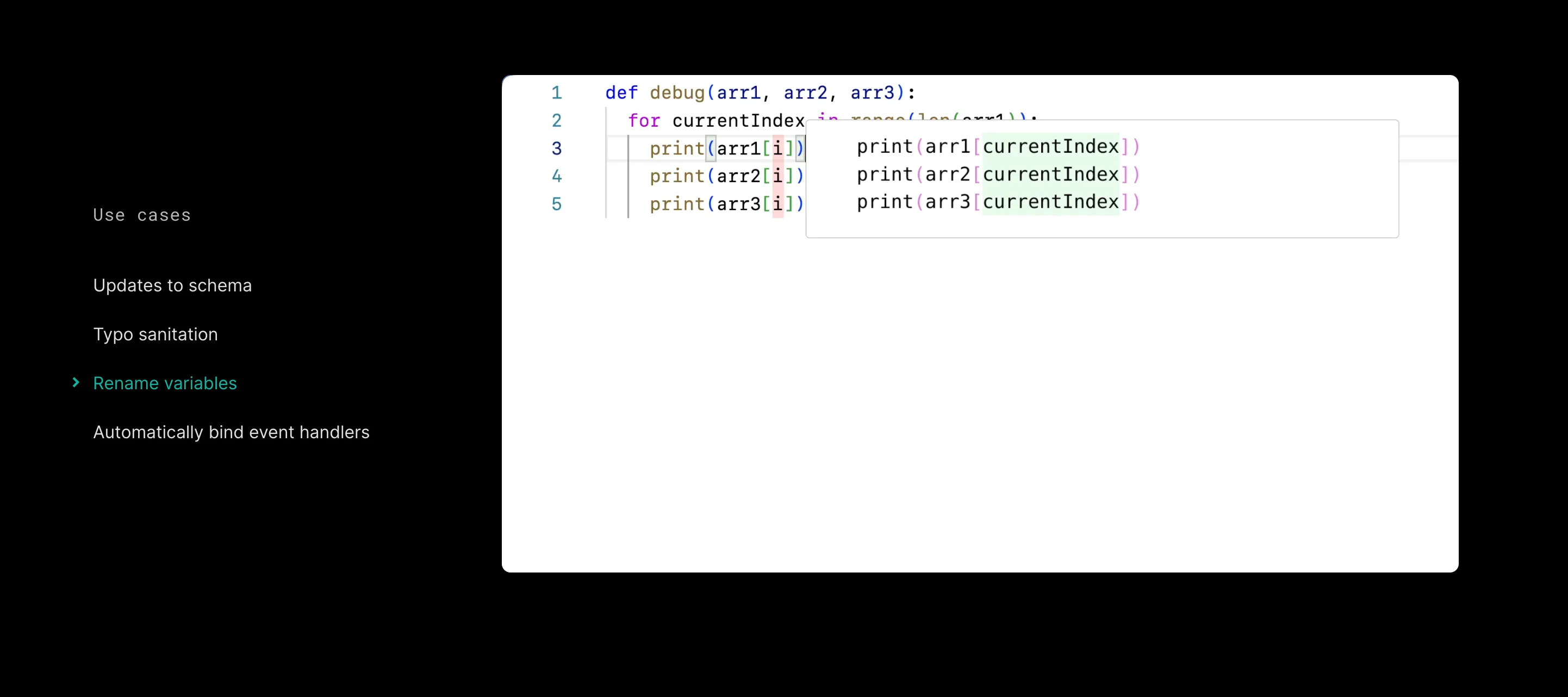

自动补全快速重构代码

比起普通的补全,Cursor或Windsurf的预测会更激进,包括多行预测、Tab预测等,这里直接使用官方图演示,实际的使用概率是非常高的。

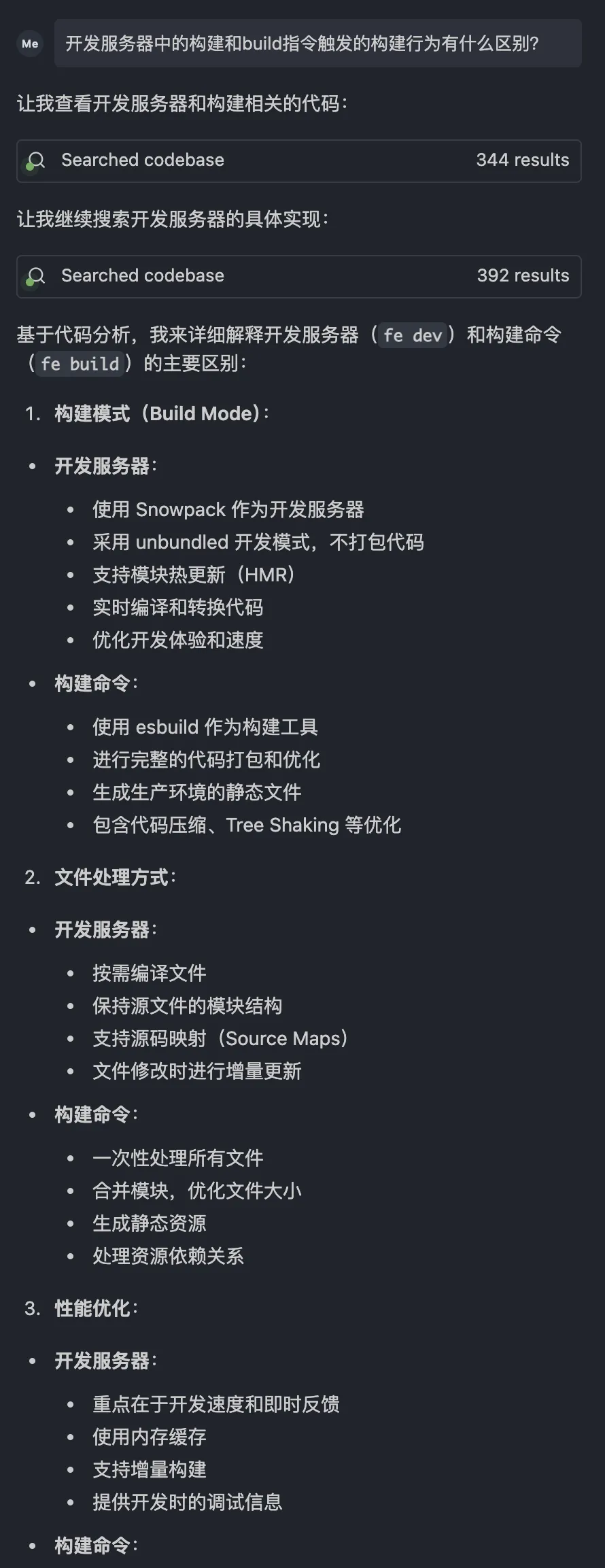

快速了解一个项目并定位代码

在老fe框架中遇到了一个问题,在不想了解已弃用的技术栈同时,又想深入到源码找到具体原因,AI IDE的仓库对话起到了重要的作用,让我原本需要花上可能一整天去了解的代码,在30分钟内快速定位并得到根本原因。

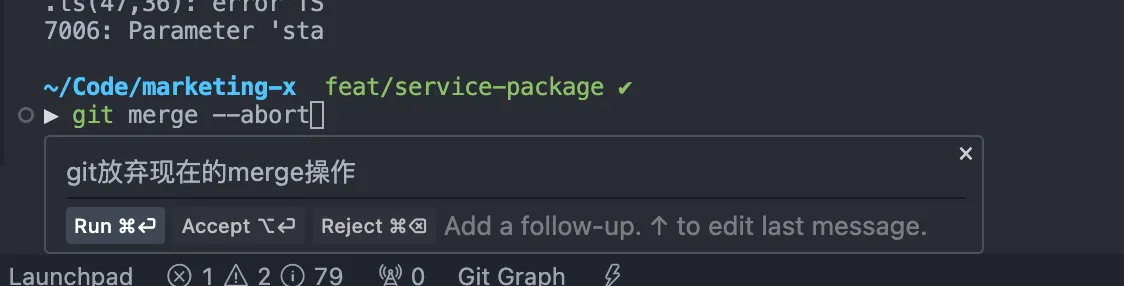

行内代码插入解决CLI命令记不住的问题

个人是经常记不住一些不常用的git操作的,这个时候我一般久唤起行内AI操作帮我写命令,省去了查询跳转的步骤。

豆包浏览器插件

豆包浏览器插件是真神级生产力工具,一己之力干趴了多个浏览器工具,而且还完全免费。

⭐️ 网页总结和询问

可以直接总结和询问当前页面,基于HTML而非视觉,支持跨页面、PDF页面等

⭐️ 网页双语对照翻译

支持调用豆包进行翻译,替代了我的沉浸式翻译

⭐️ 音视频总结

基于字幕快速帮你看完整个视频并生成总结,可以快速跳转到感兴趣的部分,并在聊天中询问视频内容,目前已不支持bilibili,但可以使用内置的「视频小助手」替代

划词工具栏

如AI搜索、划词翻译、图片工具栏等,个人不是很常用

AI辅助撰写

对所有输入框添加AI辅助撰写功能,提供润色、起草等功能,个人不是很常用